-

NGD Expansion

-

Deutschland

-

70.000 m2

-

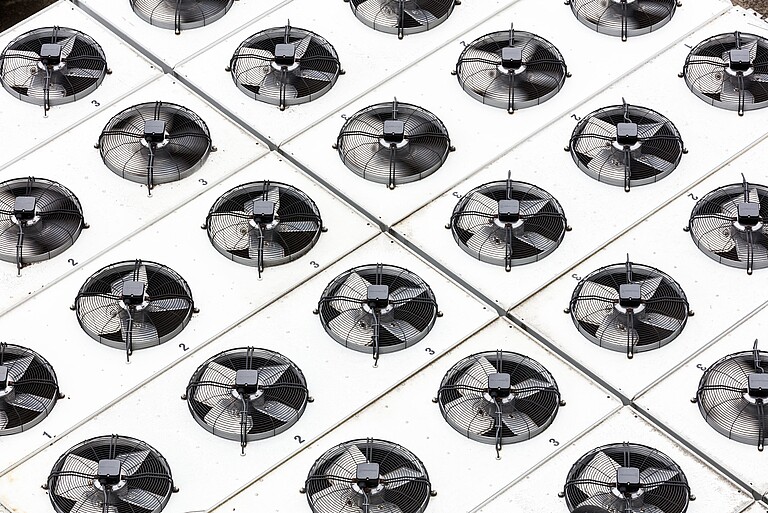

STULZ GE Hybridsysteme mit Indirekter Freier Kühlung

-

Zuverlässige und kreative Lieferkettenlösung

-

Optimierung der minimalen Leistungsaufnahme

Der Kunde

Bei NGD handelt es sich um ein speziell für diesen Zweck errichtetes Carrier-neutrales Tier-III-Colocation-Rechenzentrum, das einen hochgradig sicheren Raum mit einer Fläche von 70.000 m2 anbietet und unabhängige Services sowie belastbare Stromversorgungs- und Kühlsysteme umfasst. Anfang 2018 kündigte das Rechenzentrum angesichts einer wahren Flut von neuen Kundenverträgen mit einem Wert von über 125 Mio. £ über fünf Jahre den Ausbau des Erdgeschosses um rund weitere 9.300 m2 Kapazität an.

Phil Smith, der Bauleiter von NGD, erläutert: „Dank unseres 16-wöchigen Ausbauprogramms sind wir der Nachfrage unserer Kunden stets einen Schritt voraus. Um ein Projekt mit einer solchen Größe und Komplexität innerhalb von nur vier Monaten abzuschließen, müssen mehr als 500 Bauarbeiter ständig vor Ort sein. Damit die Arbeiten mit dem richtigen Tempo vorankommen, ist es erforderlich, dass die Lieferanten Aufbau und Bauart ihrer Produkte an den Zeitplan anpassen.“